madrid

"No hay necesidad de morir en esta guerra. Te aconsejo que vivas", ordenaba la voz del presidente ucraniano Volodímir Zelenski, en uno de los vídeos que se hizo viral en marzo de 2022. En la misma grabación, el homólogo ruso Vladímir Putin hablaba de una rendición pacífica.

A pesar de ser un vídeo manipulado de baja calidad, se difundió rápidamente, creando confusión y transmitiendo información distorsionada.

Este deepfake, es decir, esta manipulación digital hiperrealista, es uno más de los vídeos y fotos falsas que han sido publicados en el marco del conflicto entre Rusia y Ucrania. Su proliferación ha añadido aún más complejidad al paisaje informativo.

Además, este fenómeno, lejos de ser una mera curiosidad técnica, ha revelado patrones intrigantes, especialmente en la representación de figuras políticas.

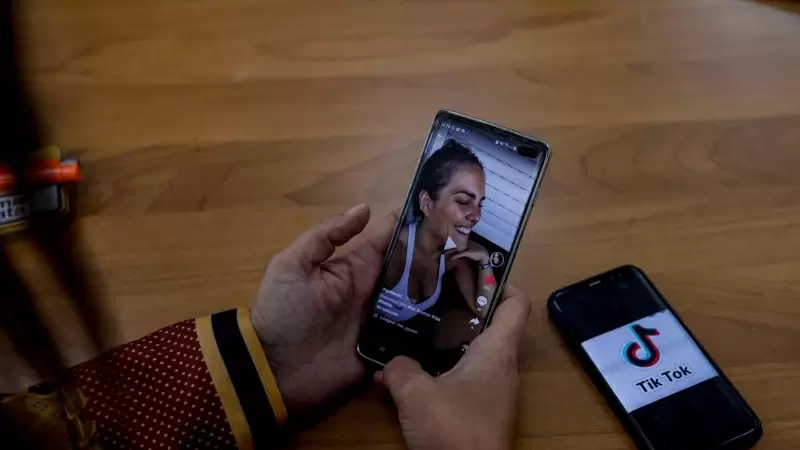

Esta investigación ha analizado centenares de deepfakes en TikTok y Telegram a través del análisis de red. Para encontrar el contenido manipulado se ha utilizado la inducción con palabras clave preseleccionadas (metodología explicada al final del texto).

Los resultados obtenidos revelan una marcada inclinación positiva hacia Rusia en el uso de deepfakes, en contraste con una perspectiva más desfavorable hacia Ucrania y Estados Unidos.

Entre los ejemplos notables se encuentran vídeos que difaman al presidente Zelenski, insinuando problemas relacionados con el consumo de drogas, como se puede observar aquí, aquí, o aquí.

Asimismo, en otros deepfakes, se ha representado al presidente ucraniano y al mandatario estadounidense Joe Biden en situaciones sexualizadas, como se evidencia aquí o aquí. Estas manipulaciones digitales no solo trascienden el ámbito político, sino que también se sumergen en terrenos de intolerancia a través de narrativas misóginas y LGTBIfóbicas.

Existen diferencias en la narrativa hacia Putin y la dirigida hacia políticos ucranianos y estadounidenses

En el caso del uso de deepfakes que representan a Putin, la tendencia es ubicarlo en situaciones aparentemente humorísticas, como por ejemplo bailando de manera desenfadada, como puede verse aquí, aquí, o aquí. Estos montajes, con un tono ligero, contrastan notoriamente con las narrativas más oscuras dirigidas hacia políticos ucranianos y estadounidenses.

La desinformación, pues, permea ambos lados del conflicto, pero es en el ámbito de los deepfakes donde se revela una diferencia significativa. La cantidad de vídeos relacionados con Putin es limitada, y estos, además, carecen de una narrativa antirrusa. Este fenómeno plantea interrogantes sobre la intencionalidad detrás de estas creaciones digitales y sus posibles implicaciones.

En el universo digital, donde los límites entre realidad y ficción son cada vez más difusos, estos montajes hiperrealistas están siendo usados como un arma más del conflicto, infiltrándose en todos los rincones de las redes sociales. A pesar de las reacciones casi inmediatas y del descrédito que tienen, su difusión es bastante eficaz en algunos casos.

La erosión democrática, el gran problema

"Somos criaturas muy visuales, lo que vemos influye en lo que pensamos, percibimos y creemos", afirma Víctor Madeira, periodista y experto en contrainteligencia y desinformación rusa.

"Los deepfakes representan solo la última arma diseñada para confundir, abrumar y, en última instancia, paralizar la toma de decisiones en un conflicto".

El poder de la desinformación resulta atractivo para las redes sociales

Si bien el objetivo es socavar la confianza en la información, los medios y la democracia, el poder resultante de estos vídeos manipulados resultan atractivos para las plataformas online como las redes sociales.

Si bien las plataformas no están legalmente obligadas a monitorear, detectar y eliminar deepfakes maliciosos, "les conviene adoptar políticas proactivas para implementar dichas herramientas y priorizar la protección del usuario", afirma el experto.

Sin embargo, las necesidades no siempre coinciden con los intereses: "Como empresas, participan en una competencia masiva para expandirse a nuevos mercados, incluso cuando no tienen la infraestructura necesaria para proteger realmente a los usuarios", afirma Luca Nicotra, director de campañas de sensibilización de la ONG Avaaz, organización que investiga la desinformación online.

Por lo tanto, ganar dinero con este tipo de información errónea y recibir comentarios positivos se vuelve más ventajoso, en lugar de crear las herramientas para prevenir su propagación y proteger a los usuarios.

"Pase lo que pase con Facebook, Telegram, Instagram y otras plataformas, es necesaria una revisión final por parte de personal capacitado, pero esto tiene un costo", destaca.

El 'boom' de la inteligencia artificial

Los avances en la IA generativa han originado cierta preocupación sobre la capacidad de la tecnología para crear y difundir información errónea a una escala sin precedentes.

"Llega un punto en el que a la gente le resulta muy difícil entender si la imagen que recibe en su teléfono es auténtica o no", afirma Cristian Vaccari, profesor de comunicación política en la Universidad de Loughborough y experto en desinformación.

El contenido producido inicialmente con unos pocos medios simples puede parecer de mala calidad, pero mediante las modificaciones necesarias puede volverse creíble. Un ejemplo reciente es el de las supuestas críticas de la esposa del presidente estadounidense Biden a su gestión de la crisis en Oriente Medio.

"Ya existen herramientas para producir deepfakes incluso con solo unas pocas frases", advierte Jutta Jahnel, investigadora y experta en inteligencia artificial del Instituto Tecnológico de Karlsruhe. "Cualquiera puede crearlos, este es un fenómeno reciente. Es un riesgo sistémico complejo para toda la sociedad".

Jahnel: "Al menos 16 países han usado la IA para sembrar dudas, denigrar a los oponentes o influir en el debate público"

De hecho, este "riesgo sistémico" tiene límites que ya ahora son difíciles de delimitar: según el último informe de Freedom House, al menos 47 gobiernos han utilizado a comentaristas progubernamentales para manipular los debates online a su favor, duplicando el número en comparación con hace una década.

Además, sobre la IA, Jahnel comenta que "durante el año 2022 al menos 16 países han usado esta tecnología para sembrar dudas, denigrar a los oponentes o influir en el debate público".

Según los expertos consultados, la situación está empeorando y no es fácil identificar a los responsables en un ambiente saturado de desinformación, en este caso, provocado por la guerra. "El conflicto entre Rusia y Ucrania está generando una mayor polarización y una mayor motivación para contaminar el entorno informativo", afirma Erika Magonara, experta de ENISA.

Del análisis de varios canales de Telegram se desprende que los perfiles involucrados en la difusión de dichos contenidos tienen características específicas.

"Existe una especie de círculo vicioso", explica Vaccari: "Las personas que confían menos en las noticias, en las organizaciones informativas y en las instituciones políticas se desilusionan y recurren a las redes sociales o a determinados círculos, siguiendo la idea de haz tu propia investigación para contrarrestar la información oficial. A causa de esto, se encuentran con contenido de baja calidad".

Las tendencias en Telegram y TikTok

Una corriente generalizada ha sido la creación de deepfakes para parodiar a los protagonistas políticos de la guerra, lo que tiene como principal consecuencia un daño personal difamatorio.

Este efecto fue confirmado por un estudio reciente realizado por el Centro de Investigación Lero de la University College Cork sobre la red social X (antes Twitter) que afirma que "los usuarios tendían a pasar por alto o incluso alentar el daño causado por los deepfakes difamatorios cuando se dirigían contra políticos rivales".

En uno de los canales de Telegram analizados se puede leer: "Observa los políticos españoles, como Sánchez, Yolanda Díaz o Montero. ¿Te parecen iguales en todos los vídeos? Hace tiempo que están usando deepfakes, no te los creas".

Apuntar a la realidad como si fuera un deepfake tiene consecuencias negativas en la percepción de la verdad. Esto refleja otra consecuencia directa de la difusión de los deepfakes en un entorno informativo ya lleno de manipulación y confusión.

Los académicos lo definen como el "dividendo del mentiroso", o incertidumbre informativa en el entorno mediático, que distorsiona aún más la realidad.

Un efecto de esto es la narrativa de que los medios occidentales utilizan la IA para manipular la percepción pública, afirmando, por ejemplo, que Rusia no está atacando zonas residenciales civiles.

Otra tendencia identificada es la ausencia de desacreditación en Telegram. La mañana del 16 de marzo de 2022 marcó uno de los primeros casos en los que se utilizó deliberadamente un deepfake político para difundir desinformación en un contexto de conflicto, lo que subraya el impacto potencial de los deepfakes.

En este caso específico, dicho contenido alimentó creencias conspirativas y generó un escepticismo dañino. Este fenómeno, además, ocurre con mayor frecuencia en ciertos países, especialmente en el sur de Europa.

La desinformación en Italia y España

Desde el inicio de la guerra, tanto Rusia como Ucrania han trabajado en las redes sociales para difundir su propaganda a través de grupos y cuentas creados específicamente para este fin.

El análisis de los distintos canales de Telegram que operan en España e Italia confirmó esta tendencia, revelando inclinaciones hacia ideologías de extrema derecha y sentimientos antisistema.

Entre las narrativas más difundidas, se encuentran elementos que proporcionan un terreno fértil para la propaganda pro-Kremlin, como teorías que niegan la masacre de Bucha, apoyan la existencia de biolaboratorios estadounidenses en Ucrania y promueven la narrativa de la desnazificación de la propia Ucrania.

Un entorno digital asediado por deepfakes se ve aún más amenazado por la falta de contramedidas adecuadas. En el caso de España, y el sur de Europa en general, "hay el doble de publicaciones desinformativas que en otros países europeos, pero, a la vez, los recursos son limitados para controlar este fenómeno", afirma Nicotra.

Los usuarios de habla española e italiana están más expuestos a la desinformación

Un informe de Avaaz de 2020 destacó esta tendencia y también subrayó cómo los usuarios de habla española e italiana están más expuestos a la desinformación. "Las redes sociales solo detectan la mitad de las publicaciones falsas porque tienen pocos incentivos para invertir en otros idiomas que no sean el inglés".

"En este momento, es una desventaja competitiva para cualquier empresa dejar de brindar a los usuarios información errónea y contenido polarizado", dice el mismo experto, ya que producen mucha más expectación e interacción que las noticias contrastadas.

Telegram en concreto no regula ni modera la información. De entre los 27 países de la Unión Europea, Italia y España son los que más utilizan esta red social, en concreto, el 27% y el 23% de la población, respectivamente, según recoge la última encuesta del Eurobarómetro.

Al considerar estos datos en relación con la desinformación, emerge una realidad preocupante que fomenta aún más la difusión de ciertas narrativas dentro de estas burbujas de información.

Como explica Madeira, la desinformación rusa se adapta a cada país o región, pero los Estados mediterráneos, en particular, tienen fama de ser blandos con Rusia y son incluso más indulgentes cuando se trata de cuestiones de seguridad en general.

Dentro de esta falta de transparencia y control sobre la desinformación, la Unión Europea ha intentado intervenir impulsando diversas leyes sobre regulación de contenidos.

La respuesta de la UE: lo que aún queda por hacer

Aprobada por el Parlamento Europeo a principios del verano pasado, la Ley de IA es la legislación más reciente que se centra en la inteligencia artificial.

Una de las medidas que incluye es el etiquetado de información errónea para contrarrestar la efectividad y dificultar la generación de contenidos ilícitos.

"Introduce obligaciones y requisitos graduados en función del nivel de riesgo, con el fin de limitar los impactos negativos sobre la salud, la seguridad y los derechos fundamentales", explica el eurodiputado Brando Benifei en una entrevista para este reportaje.

"Lo que está cambiando, sin embargo, es el grado de responsabilidad que las instituciones de la UE asignan cada vez más a las redes sociales que amplifican este contenido".

Se trata, por tanto, de establecer el nivel de compromiso de lo que sucede, no solo a nivel institucional, sino también por parte de las plataformas implicadas: "Si aceptas deepfakes en tu plataforma, eres responsable de este contenido. Eres responsable de los riesgos estructurales porque actúas como amplificador de esta desinformación", afirma Dragos Tudorache, también eurodiputado y correlator de la ley.

Hace menos de dos años que presenciamos por primera vez propaganda y desinformación a través de la herramienta del deepfake que intentaba influir en una guerra.

A pesar de la publicación de la Ley Europea de Servicios Digitales, que establece las bases para controlar la desinformación en las redes sociales, "la IA ha hecho de la desinformación una tendencia, facilitando la creación de contenido falso", afirma Magonara.

El deepfake en sí representa una técnica de guerra diseñada para alimentar ciertos tipos de discurso y estereotipos fácilmente compartidos. En un conflicto que no muestra signos de amainar, como sostiene Magonara, "el verdadero objetivo es la sociedad civil".

Esta investigación ha sido posible gracias al apoyo de IJ4EU

Esta investigación ha analizado centenares de deepfakes presentes en TikTok y Telegram usando el análisis de red, es decir, se han estudiado las conexiones entre las deepfakes, las cuentas que los difunden y los usuarios que las comparten y se han establecido relaciones entre ellas. De esta manera, se ha podido identificar todo el plano comunicativo de desinformación y, a través del método de bola de nieve, se ha comenzado por las cuentas más famosas ya identificadas en estudios previos.

Además, el contenido manipulado se ha identificado por inducción, es decir, se ha llegado a las conclusiones a través de la detección y análisis de palabras claves relacionadas con este tipo de desinformación que se han escogido previamente.

¿Te ha resultado interesante esta noticia?

Comentarios

<% if(canWriteComments) { %> <% } %>Comentarios:

<% if(_.allKeys(comments).length > 0) { %> <% _.each(comments, function(comment) { %>-

<% if(comment.user.image) { %>

![<%= comment.user.username %>]() <% } else { %>

<%= comment.user.firstLetter %>

<% } %>

<% } else { %>

<%= comment.user.firstLetter %>

<% } %>

<%= comment.user.username %>

<%= comment.published %>

<%= comment.dateTime %>

<%= comment.text %>

Responder

<% if(_.allKeys(comment.children.models).length > 0) { %>

<% }); %>

<% } else { %>

- No hay comentarios para esta noticia.

<% } %>

Mostrar más comentarios<% _.each(comment.children.models, function(children) { %> <% children = children.toJSON() %>-

<% if(children.user.image) { %>

![<%= children.user.username %>]() <% } else { %>

<%= children.user.firstLetter %>

<% } %>

<% } else { %>

<%= children.user.firstLetter %>

<% } %>

<% if(children.parent.id != comment.id) { %>

en respuesta a <%= children.parent.username %>

<% } %>

<%= children.user.username %>

<%= children.published %>

<%= children.dateTime %>

<%= children.text %>

Responder

<% }); %>

<% } %> <% if(canWriteComments) { %> <% } %>