Madrid

Actualizado:La desinformación es un fenómeno antiguo, lo que es nuevo es su difusión masiva. Cada vez más nos informamos y compartimos datos por redes sociales, que solían ponerse de lado ante este fenómeno hasta que estallaron escándalos como el de Cambridge Analytica. Ahora que hasta los gobiernos se fijan en el asunto, los gigantes de la red parecen preocupadísimos con el fenómeno, que puede menoscabar aún más la confianza de los usuarios (y anunciantes), y que incluso les puede acarrear problemas legales. ¿Cómo se están implicando en frenar la difusión de bulos, verdades a medias o discursos de odio en las redes, sin que ello suponga un recorte de la libertad de expresión?

En los últimos días, las grandes redes sociales y plataformas de Internet se han lanzado a elaborar intensas campañas de relaciones públicas en los principales países de Europa; responsables regionales y globales de políticas públicas han ido explicando en discretas reuniones con partidos políticos y periodistas sus esfuerzos para tratar de mitigar el fenómeno de la desinformación con similares estrategias.

Todo ello cuando apenas queda un mes para la celebración de importantísimas jornadas electorales en España, el 28 de abril (comicios generales y valencianos) y en toda Europa el 26 de mayo, el mismo día de las municipales y autonómicas en nuestro país, además.

El temor a la distribución masiva y segmentada de mensajes con el fin de influir en las elecciones está sobre la mesa. Y especialmente cuando en España, la última reforma de la Ley Electoral (vía Ley Orgánica de Protección de Datos) habilita a las claras que los partidos políticos puedan rastrear datos de los ciudadanos por internet y utilizarlos para distribuir sus mensajes prácticamente a medida de cada uno.

En este contexto, y a pesar de los esfuerzos para poner coto a esa disposición y proteger a los ciudadanos de manipulaciones interesadas, las redes sociales y las compañías de internet se han visto obligadas a mover ficha, como parte imprescindible de la difusión masiva de este tipo de mensajes.

A grandes pinceladas, compañías como Facebook, Google y Twitter apuestan fundamentalmente por tres acciones: detectar comportamientos 'sospechosos' mediante inteligencia artificial y la ayuda de los usuarios, penalizar (no eliminar del todo) los contenidos con clara intención manipuladora y proporcionar contexto al usuario.

Facebook (e Instagram)

La compañía de Mark Zuckerberg — 2.700 millones de usuarios en todo el mundo— ha enviado a Tessa Lyons, jefa de producto de Facebook y responsable del equipo de lucha contra la desinformación y las noticias falsas, a explicar con detalle la estrategia de la red social, que es prácticamente la misma para Instagram y que será común para todo el mundo de forma progresiva.

Lyons anunció esta semana en Madrid que a partir de la semana que viene, en toda Europa —en España también—, la red social pondrá en marcha un sistema de identificación de anuncios políticos, los cuales deberán mostrar al usuario a quién está dirigida, cuánto dinero se ha invertido, cuánta gente la ha visto y quién la está pagando.

Estos anuncios sólo los podrán poner cuentas autenticadas de organizaciones o personas que demuestren que son del país, para limitar las injerencias externas. Esta información generará un archivo público en donde se almacenará durante siete años.

Más en general, esta responsable explicó que:

1) La red social borra contenidos si violan sus condiciones de uso, especialmente cuando se trata de contenidos ilegales, discurso de odio, abusos... Y borra cuentas falsas: hasta 754 millones en el tercer trimestre del pasado año, por ejemplo.

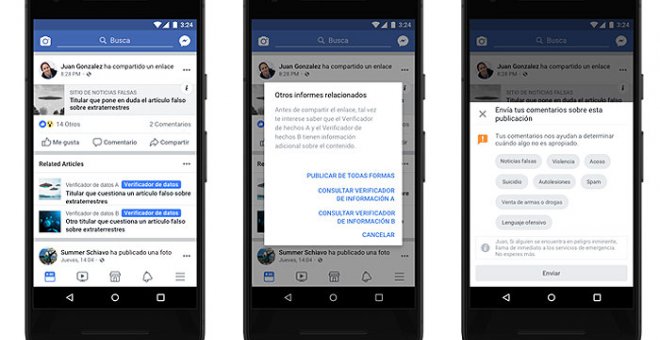

2) Los bulos y la desinformación no se borran, pero sí se 'penalizan': se muestran menos en News Feed de Facebook al recibir menos puntuación, de forma que se limita su difusión y alcance.

3) Adicionalmente, la compañía ofrecerá información de contexto (mediante un "botón de contexto") en noticias de carácter político, con enlaces a otras noticias de sitios 'confiables', información sobre quién publicó primero ese contenido y datos extraídos de la Wikipedia. Si son sospechosas, un aviso nos ofrecerá esa información antes de compartir.

Para detectar tanto desinformación como comportamientos sospechosos, la compañía pasa por su algoritmo de detección todo lo que cada usuario sube cada vez. "Hay cientos de miles de señales que vamos recopilando en nuestro inventario para realizar predicciones y otorgar puntuaciones a usuarios, de modo que podamos predecir mejor información potencialmente dañina y saber quién y cómo se comparte", explica Lyons.

Una vez identificada la información 'sospechosa', bien porque la gente está reportando a Facebook que podría ser falsa o dañina, bien porque el algoritmo la señala, la compañía realizará un trabajo de 'fact checking' o comprobación. Y para comprobar los mensajes políticos sospechosos, ha cerrado acuerdos con 43 organizaciones de verificación certificados e independientes que trabajan en 22 idiomas. En España son tres: Maldita, Newtral y AFP.

Asimismo, contará con un equipo de verificación específico para elecciones con sedes en Dublín, California y Singapur, además de los centros de control humano sobre sus contenidos en general, actualmente con 20.000 trabajadores, repartidos por el mundo (en Barcelona, por ejemplo, cuenta con 500 personas).

Aunque pertenezca a Facebook y no sea una red social, este popular servicio de mensajería ha sido clave en la distribución de bulos y desinformación en países como Brasil o la India, especialmente en periodos electorales pero no únicamente. La complicación de controlar la difusión de los mensajes falsos es mayor aquí, al tratarse de una herramienta que se utiliza en conversaciones privadas de los ciudadanos.

"Al ser un producto completamente distinto a Facebook e Instagram, dado que es un servicio de mensajería entre particulares cuyos contenidos están cifrados, la estrategia aquí tiene que ser distinta", comentaba un alto responsable a Público, de visita en Madrid y a quien Facebook no permite atribuirle personalmente sus comentarios.

WhatsApp ya ha tomado algunas medidas para frenar, en general, la capacidad de cada cuenta para reenviar contenidos a personas o grupos: sólo cinco veces. Además, el máximo número de personas que pueden formar parte de un grupo es 256. También está implementando más medidas, como la posibilidad de que no puedan meterte en un grupo sin permiso, de momento en pruebas.

Las medidas que puede tomar WhatsApp contra penalizar los bulos se reducen a una: eliminar cuentas que violan sus términos y condiciones de uso.

Como no puede monitorizar el contenido de mensajes privados, la compañía se fija en determinadas señales que indican un comportamiento 'anormal' de la aplicación y que analiza mediante algoritmos: desde cómo te registras, hasta cuántos mensajes envías, a cuántos grupos perteneces o si incorporas una lista inusualmente larga de contactos.

Ello, unido a la posibilidad de que otro usuario pueda reportar al servicio una conducta sospechosa o abusiva, puede llevar a la plataforma a eliminar tu cuenta. "Eliminamos unas dos millones de cuentas al mes, y el 75% de ellas son máquinas o bots", comenta el responsable.

WhatsApp también trata de educar a los usuarios en el buen uso del servicio. Por ejemplo, esta semana los partidos políticos españoles fueron invitados a una reunión con el mismo alto responsable de esta plataforma con quien ha hablado este medio, para recordarles cuáles son las prácticas a evitar. Ningún partido político preguntado por Público respondió si había acudido a esta convocatoria excepto Ciudadanos que, en un breve mensaje, afirmó a este medio: "Lamentablemente desconocemos esa información".

Como consejo adicional, por favor: si sospechas que una información no es correcta, está manipulada o es demasiado buena para ser verdad, rompa la cadena y no la reenvíe. Y si tiene un alto contenido político que no ha solicitado, repórtelo. Aunque se lo reenvíe su madre, su mejor amigo, los del grupo del gimnasio o su cuñado.

El gigante de las búsquedas por internet también está haciendo esfuerzos para frenar la difusión de desinformación en las redes de cara a las convocatorias electorales, especialmente las europeas del 26 de mayo. Y su trabajo es clave, dado que el buscador es prácticamente la puerta de entrada a cualquier consulta que se realiza en internet, y su algoritmo ordena las respuestas de forma que los primeros puestos son naturalmente los más relevantes.

El punto de partida de la compañía es que no realizan tareas editoriales, sostienen, por lo que evita incluso fijar qué es desinformación y qué no. "Como queremos poner en valor qué es información de calidad, lo que hacemos es asociarnos con los expertos, fundamentalmente periodistas", comentan responsables europeos de la compañía, que se muestran públicamente comprometidos con el 'periodismo de calidad'.

Existen tres "pilares" de actuación del gigante de internet, de acuerdo con uno de sus responsables a nivel europeo.

1) Por un lado, está invirtiendo en la formación de periodistas en el uso de herramientas para comprobar la veracidad de los datos. "Las técnicas de desinformación cambian a cada momento, por eso la formación de los periodistas es fundamental", explican fuentes de la compañía, que afirman que ya han 'entrenado' a 200 periodistas.

2) En segundo lugar, apoyan, la iniciativa CrossCheck —apoyada por Google News Lab, que provee dinero e infraestructura, pero que lidera la coalición de noticias First Draft con una lista importante de medios de comunicación franceses para los comicios de 2017— y propone una serie de eventos en los que de forma intensiva se intercambian experiencias entre las organizaciones dedicadas el 'fact checking' y los medios de comunicación.

3) Por último, Google anuncia la iniciativa 'Fact Check EU', que lidera la IFCN (Red Internacional de Comprobadores, por sus siglas en inglés), que supone desarrollar un motor de búsqueda para que cualquier persona pueda preguntar ahí por la verificación de informaciones relacionadas con las elecciones europeas, sobre una base de datos de bulos y desinformaciones aportadas por 90 organizaciones en 30 países y 10 idiomas. En España, el proyecto lo liderará Maldita junto a Newtral.

De esta manera, si alguien pregunta en Google si algo es cierto o no, y hay un trabajo de verficación previo, ese trabajo aparecerá en un lugar destacado en los resultados, porque el algoritmo así lo reconocerá.

YouTube

La popular plataforma de publicación de vídeos ha sido —y es un campo abonado para la distribución de desinformación y polarización, especialmente de la extrema derecha. Y contribuye de forma especialmente notable a la creación de lo que se conoce como "filtro burbuja": uno consulta un vídeo y YouTube recomienda contenidos similares o infiere sus gustos para servirle lo que uno, supuestamente, quiere ver. Es algo que la propia plataforma reconoce, de hecho.

No obstante, desde YouTube sostienen que publicar cómo funciona el algoritmo que selecciona los vídeos recomendados podría impulsar maniobras de actores "indeseables" para, precisamente, promover sus mensajes.

Así, la compañía está probando las siguientes medidas:

1) Por un lado, cuando se produce una noticia de 'última hora', el algoritmo tiende a destacar vídeos de medios de comunicación registrados y profesionales, de modo que el contenido de baja calidad o que directamente propaga desinformación no se muestra en los lugares destacados en los resultados de búsqueda.

2) Contexto: la plataforma sostiene no 'censura' contenidos excepto aquellos que son contrarios a las leyes de cada país. Por tanto, YouTube trata de añadir contexto a los vídeos considerados sospechosos, con enlaces a sitios como la Enciclopedia Británica o Wikipedia, aunque esta función no se encuentra disponible en todo el mundo.

3) Asimismo, apoyan proyectos académicos para investigar este fenómeno y mejorar su capacidad de detección de contenidos relacionados con la desinformación.

La red social más abierta y preferida por los periodistas en España— en también la red que puede prestarse especialmente a abusos y distribución de desinformación, fundamentalmente por dos factores: la facilidad con la que se puede abrir una cuenta, y su diseño pensado fundamentalmente para compartir rápidamente contenidos. Existen ejemplos numerosos y documentados, dado el carácter abierto de esta red social.

Desde la compañía, que también aportaron esta semana contexto con responsables europeos, destacan tres formas de luchar contra la desinformación:

1) En primer lugar, Twitter asegura que trabaja para "mejorar sus sistemas automáticos de detección y eliminación de cuentas falsas".

2) En segundo lugar, la compañía intenta afinar la detección de contenidos indeseables, como discursos de odio y otros que violen sus términos y condiciones de usos, gracias a la combinación de las denuncias de los usuarios —cada tuit puede ser reportado, silenciado o bloqueado por cualquier usuario— combinado con inteligencia artificial, que busca patrones de conducta.

3) Por último, esta red social apuesta por la transparencia en los contenidos patrocinados: los tuits de carácter político pagados, afirman, deberán estar "certificados", esto es, sus promotores identificados para que los usuarios puedan saber su origen.

Como dato curioso, la compañía sostiene que no ha detectado ninguna actividad "extraña" en su herramienta de mensajes directos, que funciona prácticamente como un servicio de mensajería: los mensajes no son públicos —aunque sus contenidos no están cifrados— y se pueden establecer grupos.

¿Te ha resultado interesante esta noticia?

Comentarios

<% if(canWriteComments) { %> <% } %>Comentarios:

<% if(_.allKeys(comments).length > 0) { %> <% _.each(comments, function(comment) { %>-

<% if(comment.user.image) { %>

![<%= comment.user.username %>]() <% } else { %>

<%= comment.user.firstLetter %>

<% } %>

<% } else { %>

<%= comment.user.firstLetter %>

<% } %>

<%= comment.user.username %>

<%= comment.published %>

<%= comment.dateTime %>

<%= comment.text %>

Responder

<% if(_.allKeys(comment.children.models).length > 0) { %>

<% }); %>

<% } else { %>

- No hay comentarios para esta noticia.

<% } %>

Mostrar más comentarios<% _.each(comment.children.models, function(children) { %> <% children = children.toJSON() %>-

<% if(children.user.image) { %>

![<%= children.user.username %>]() <% } else { %>

<%= children.user.firstLetter %>

<% } %>

<% } else { %>

<%= children.user.firstLetter %>

<% } %>

<% if(children.parent.id != comment.id) { %>

en respuesta a <%= children.parent.username %>

<% } %>

<%= children.user.username %>

<%= children.published %>

<%= children.dateTime %>

<%= children.text %>

Responder

<% }); %>

<% } %> <% if(canWriteComments) { %> <% } %>